Tentative de traduction en anglais disponible sur LinkedIn

En résumé

La proposition de règlement de la Commission européenne présentée le 21 avril 2021 vise à encadrer de manière horizontale et transversale toutes les différentes applications de l’intelligence artificielle (IA). Cette proposition s’intègre dans une plus vaste stratégie de la Commission sur le numérique dont un nouveau plan coordonné sur l’IA pour 2021.

La proposition distingue 4 types d’applications, avec des contraintes à l’intensité décroissante : 1) les applications prohibées du fait de leur nature (influence sur les comportements avec des conséquences physiques ou psychologiques, crédit social et reconnaissance faciale dans l’espace public – avec de très larges exceptions pour un usage d’enquête judiciaire), 2) les applications à haut risque devant répondre à des exigences clés et à un mécanisme d’évaluation de la conformité préalable à la mise sur le marché, 3) les applications à risque limité, auxquels sera imposé une obligation spécifique de transparence (comme les chatbots ou les deepfakes), et 4) celles enfin présentant un risque minimum. Des sanctions financières allant jusqu’à 6% du chiffre d’affaires annuel pourront être prononcées en cas de manquement d’un opérateur privé.

Dans le même temps le texte vient soutenir l’innovation en autorisant des textes d’encadrement juridique temporaires pour l’expérimentation (« bacs à sable » réglementaires), ce qui intéressera particulièrement les micros, petites et moyennes entreprises. L’adoption de codes de conduite sectoriels est également encouragée.

Un comité européen sur l’intelligence artificielle, composé de représentants des 27 États membres et du contrôleur européen de la protection des données, sera aussi constitué.

Une proposition de réglement cherchant à concilier protection des individus, sécurité juridique et innovation

La Commission européenne vient de publier le 21 avril 2021 sa proposition de règlement[1] de l’intelligence artificielle (« IA[2] »), en même temps qu’un projet de réglement sur les machines et après un leak opportun d’une version de travail quelques jours auparavant. Cette fuite aura permis de mobiliser une large communauté de commentateurs de toutes sortes et d’anticiper, avant la publication du texte final, les plus fortes critiques – substantielles, nous le verrons. Il est à noter que texte s’intègre dans une stratégie plus globale sur le numérique et accompagne également un nouveau plan coordonné sur « l’IA[3] » pour 2021.

« Les mesures proposées par la Commission se dévoilent enfin avec ce qui pourrait paraître comme étant une première satisfaction pour les défenseurs des droits individuels : le caractère contraignant de ces mesures »

À la suite de la publication d’un livre blanc en février 2020 et d’un large processus de consultation, les mesures proposées par la Commission se dévoilent enfin avec ce qui pourrait paraître comme étant une première satisfaction pour les défenseurs des droits individuels : le caractère contraignant de ces mesures, assorties de sanctions financières potentiellement élevées en cas de manquement (art. 71 de la proposition, qui fixe le montant d’amendes entre 2, 4 ou 6% du chiffre d’affaires annuel selon les hypothèses).

Malgré de forts vents contraires[4], la Commission engage donc l’UE sur un terrain redouté par nombre d’entrepreneurs, notamment les micros, petites et moyennes entreprises, pour faire peser sur leur activité de nouvelles contraintes que certains ne manqueront pas de considérer comme bureaucratiques. La solution imaginée par la Commission consiste en une approche « robuste et flexible » fondée sur les risques (p.3 de la proposition[5]), anticipée en Allemagne par la Commission éthique des données[6], afin de ne pas faire peser les mêmes contraintes sur toutes les applications de « l’IA ». Habile approche, dévoilée dès le livre blanc de février 2020, qui n’avait toutefois pas manqué de susciter des réactions extrêmement mitigées, voire hostiles, en se demandant comment définir une application « à haut risque » des autres et – surtout – en évoquant un réel affaiblissement d’une approche de réglementation fondée sur des droits invocables pour tout emploi de cette technologie[7]. Car c’est bien là la difficulté majeure d’un cadre juridique intervenant pour réguler l’application d’une technologie aussi transversale que « l’IA » : ouvrir des brèches dans la logique et l’enchevêtrement des mécanismes juridiques déjà existants, complexes et « interreliés ».

Cette proposition ouvre également une autre brèche en ce qui concerne des applications sensibles de l’IA, notamment à des fins d’enquête judiciaire. L’emploi de technologies comme la reconnaissance faciale dans l’espace public, pourtant régulièrement dénoncé même par des opérateurs privés comme Microsoft[8], se trouve ainsi légitimé par ce texte du fait d’exceptions si larges que le principe annoncé de sa prohibition (art.5) vient à perdre une partie de son sens. Par ailleurs, les risques les plus substantiels, comme les biais pouvant renforcer ou créer des discriminations dans des algorithmes de services publics par exemple, sont traitées par des procédures de conformité préalables à même de garantir un certain nombre d’exigences. Ainsi énoncé, le principe pourrait paraître satisfaisant, mais les métriques des standards matérialisant ces exigences et l’autorité en charge de les définir demeurent encore trop vagues pour être totalement convaincants.

Sans prétendre à l’exhaustivité et même si l’adoption effective de ce texte prendra encore probablement des années (il aura fallu pres de 4 années au RGPD pour voir le jour), cette première analyse à chaud se propose d’exposer les éléments notables d’un projet de régulation extrêmement ambitieux qui cherche à concilier protection des individus, sécurité juridique et innovation… en plus de positionner opportunément les institutions de l’UE en véritables métronomes des développements de « l’IA » dans ses États membres (section 5.2.6 p.15 et art.56).

Une définition extensive de « l’IA »

Dans son texte, la Commission commence par trancher la question de l’objet à appréhender sous le terme vague « d’IA ». La Commission a décidé d’employer la notion de « système d’IA », qu’elle a entendu définir clairement pour concilier sécurité juridique et flexibilité pour l’avenir (point 6 du préambule, p.18).

L’article 3.1 définit donc un système d’IA comme « un logiciel développé à l’aide d’une ou plusieurs des techniques et approches énumérées à l’annexe I et capable, pour un ensemble donné d’objectifs définis par l’homme, de générer des résultats tels que du contenu, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels ils interagissent ». Même si la Commission entend rester le plus neutre technologiquement (section 3.1 p.8 et 5.2 p.12), l’article 3 renvoie tout de même à une annexe I technique, qui couvre de manière très large diverses techniques algorithmiques, tant « symboliques » que « connexionnistes »[9].

« Le premier fait majeur est l’important tournant stratégique que constitue cette réglementation »

Après des décennies d’une extrême prudence à réguler les développements numériques, hormis sous l’angle de la protection des données ou de la lutte contre la cybercriminalité, le premier fait majeur est l’important tournant stratégique que constitue cette réglementation. Ne l’oublions pas, cette initiative est l’une des composantes d’une stratégie clairement énoncée dans les lignes politiques 2019-2024 de la Commission et à laquelle vont contribuer d’autres textes comme le Digital Market Act[10], Digital Service Act[11], Data Governance Act[12], Open Data Directive[13] et d’autres initiatives de l’UE sur les données[14]. L’Europe compte pleinement s’imposer en gardien des valeurs dans le nouvel environnement numérique et – surtout – jouer pleinement de son expérience de régulateur pour aligner les opérations de ses concurrents directs (américains et asiatiques) sur son rythme.

L’examen de la conformité des systèmes d’IA à haut risque

Le point le plus substantiel de la proposition est le mécanisme d’examen de la conformité des systèmes d’IA représentant le plus de risques pour les individus.

La proposition de la Commission européenne classifie donc les systèmes d’IA en quatre groupes : a) ceux créant un risque inacceptable (art.5), b) ceux à haut risque (art.6 et s.) et c) ceux avec un risque faible (art. 52), devant répondre à des exigences de transparence (comme les chatbots, où l’on devra savoir que l’on se trouve face à une « IA », ou les deepfakes) ou d) minimum (p.13).

Nous ne développerons ici l’analyse des articles relatif aux systèmes créant des risques inacceptables, regroupant notamment des systèmes ayant des risques physiques ou psychologiques sur les individus ou encore les systèmes dits de crédit social[15]. La reconnaissance faciale dans les espaces publics est aussi prohibée par principe, sauf exception pour des enquêtes judiciaires (cf.infra).

Les systèmes à haut risque sont définis par plusieurs critères, plus précis que ceux présentés en février 2020 dans le livre blanc de la Commission. La proposition identifie tout d’abord les systèmes d’IA étant une composante de produits faisant déjà l’objet d’une certification tierce-partie (p.13 et art.6.1) des systèmes autonomes d’IA ayant des impacts prévisibles sur les droits fondamentaux (p.13 et art.6.2). Une annexe vient compléter l’article 6.2, en listant 8 domaines sensibles : identification biométrique des individus, gestion des infrastructures critiques, éducation, recrutement et gestion des carrières, divers services publics et privés (dont services d’urgences, attribution de crédits, aides sociales), maintien de l’ordre et enquêtes pénales, migration et contrôle des frontières, justice (annexe III).

La Commission s’autorise à mettre à jour l’annexe listant les applications sensibles, dès lors que des systèmes a) peuvent créer des dommages sur la santé ou la sécurité des individus, ou b) sont susceptibles de provoquer des atteintes à leurs droits fondamentaux dans les domaines précédemment spécifiés (art. 7).

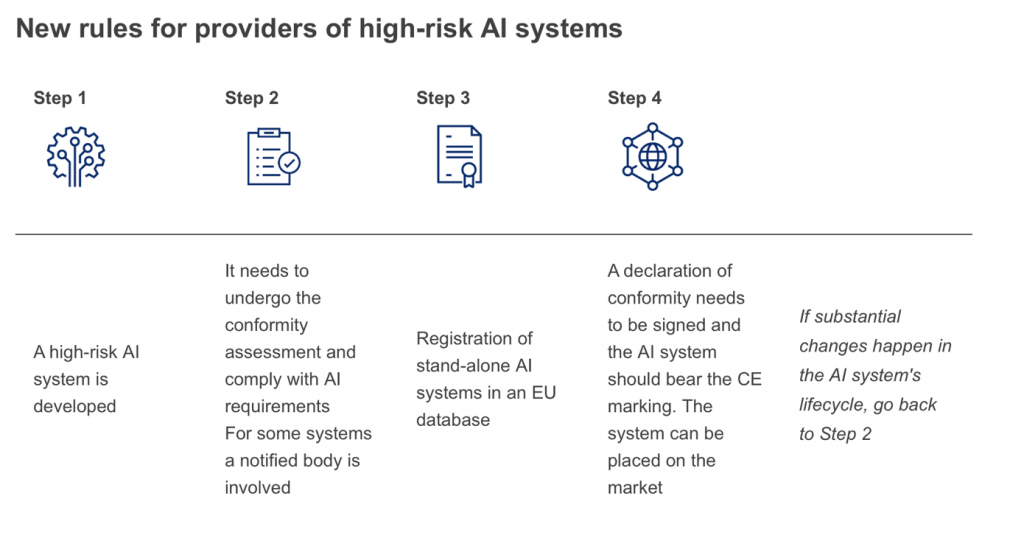

Très concrètement, pour être mis sur le marché ces systèmes devront répondre à des exigences clés, principalement issues des lignes directrices du groupe d’experts indépendants de haut niveau mandaté par la Commission, vérifiés lors d’une procédure d’évaluation de conformité ex-ante sous la responsabilité des fournisseurs. Pour ces systèmes à haut risque, la Commission impose par ailleurs un système de gestion des risques à mettre en œuvre tout au long du cycle de vie des applications concernées (art. 9) ainsi qu’une méthodologie de gouvernance des données, afin de garantir un niveau élevé de qualité (art. 10).

Ces systèmes se voient aussi imposer une documentation spécifique (point faible de la plupart des développements informatiques – art. 11 et annexe IV) et un enregistrement d’événements à même d’assurer la traçabilité des opérations (art. 12). La transparence de ces systèmes et l’information aux usagers est garantie par la fourniture obligatoire d’un certain nombre d’informations (art. 13). La supervision humaine doit être garantie en tenant notamment compte de biais cognitifs connus (biais d’automatisation) conduisant des professionnels à s’appuyer sur des systèmes automatisés sans avoir recours à leur expertise (art. 14, 4, b). Enfin la précision, la robustesse et la sécurité de ces systèmes doivent être particulièrement garanties (art. 15). On retrouve là traduit les 7 exigences des lignes directrices en matière d’éthique pour une IA digne de confiance du groupe d’experts indépendants de haut niveau[16], auxquels sont ajoutées un certain nombre d’obligations aux fournisseurs de ces systèmes à haut risque et autres parties (Chapitre 3, art. 16 à 29). Les États membres sont, par ailleurs, invités à désigner une autorité notifiante comme responsable du suivi des procédures relatives aux systèmes à haut risque et un organisme notifié (Chapitre 4, art. 30 à 39), tout à fait classique des mécanismes de certification déjà en œuvre. Un label « CE » sera délivré aux systèmes conformes (art. 49).

Les procédures d’évaluation de la conformité à suivre pour chaque type de système d’IA à haut risque tentent de minimiser la charge pour les opérateurs économiques, ainsi que pour les organismes notifiés (Chapitre 5, art. 40 à 51). Les systèmes d’IA destinés à être utilisés comme composants de sécurité de produits réglementés par la législation relative au nouveau cadre législatif (par exemple, machines, jouets, dispositifs médicaux, etc.) seront soumis aux mêmes mécanismes de conformité et d’application ex ante et ex post que les produits dont ils sont un composant, en y ajoutant les exigences établies par le nouveau règlement. Le fournisseur devra suivre soit la procédure d’évaluation de la conformité sur la base du contrôle interne visée à l’annexe VI, soit la procédure d’évaluation de la conformité fondée sur l’évaluation du système de gestion de la qualité et l’évaluation de la documentation technique, avec l’intervention d’un organisme notifié, visée à l’annexe VII (art.43). L’initiative de la mise en conformité repose, en toute hypothèse, sur le fournisseur. Une base de données enregistrera les systèmes autonomes d’IA à haut risque (art. 60). Des sanctions pourront être prononcées en cas de manquement, entre 2, 4 ou 6% du chiffre d’affaires annuel selon les situations (art. 71).

Enfin, et cela intéressera particulièrement les micros, petites et moyennes entreprises, des expérimentations pourront être menées dans un cadre juridique adapté (boîtes à sable réglementaires), même dans des domaines sensibles et avec des données à caractère personnel (art. 53 et s.). La mise en œuvre de codes de conduite sectoriels est également encouragée (art. 69).

« La Commission n’a pu échapper à une certaine complexité pour la mise en conformité des applications présentant le plus de risque de dommage sur les individus »

En résumé, la Commission n’a pu échapper à une certaine complexité pour la mise en conformité des applications présentant le plus de risque de dommage sur les individus. La classification des systèmes va certainement ouvrir à des interprétations et des débats, des opérateurs pouvant être tentés d’éviter la régulation contraignante pour des applications à la limite du haut risque (est-ce qu’un potentiel système de gestion des audiences dans les tribunaux représente un « haut risque » par exemple ?). Le prononcé de sanctions au titre des éventuels manquement devra également prendre en compte la concurrence possible entre différents ordres de juridictions (pénales et administratives), problématique déjà connue entre les autorités de protection des données et les juridictions pénales notamment.

L’exception sécuritaire

Les risques de surveillance de masse de la population avec les technologies numériques sont régulièrement soulevés par la société civile et les défenseurs des droits individuels. Avec la reconnaissance faciale et sa mise en œuvre effective dans l’espace public, dans des cadres juridiques relativement flous, ces inquiétudes se sont renforcées substantiellement, soutenues même par des fournisseurs privés de ces solutions. La Commission fait ici le choix de bannir de l’espace public ces dispositifs d’identification en temps réel des individus, avec une très large série d’exceptions au bénéfice des procédures judiciaires.

Ainsi, « l’identification biométrique à distance en temps réel » est autorisée a) pour la recherche d’enfants disparus, b) en cas de menace imminente pour la sécurité des personnes ou d’attaques terroristes, c) la détection, la localisation, l’identification ou la poursuite d’un suspect recherché pour la commission d’une infraction pénale[17] punie dans l’État membre concerné d’une peine d’emprisonnement d’au moins trois ans (art. 5, 1, d).

La Commission souligne que l’utilisation de ces systèmes à des fins répressives doit également tenir compte des éléments suivants de la nature de la situation donnant lieu à l’utilisation éventuelle, et des conséquences de l’utilisation du système sur les droits et libertés de toutes les personnes concernées (art. 5.2), en y ajoutant des limites temporelles et géographiques. Comme pour les contrôles d’identité déjà encadrés par les lois processuelles en matière pénale, une autorisation préalable devra être accordée par une autorité judiciaire ou par une autorité administrative indépendante, sur demande motivée des services de police. Toutefois, dans une situation d’urgence dûment justifiée, l’utilisation du système peut être commencée sans autorisation et l’autorisation ne peut être demandée que pendant ou après l’utilisation (art. 5.3). Ces dispositions devront être transcrites dans une loi spécifique, aménageant recours et dispositifs de supervision (art.5.4).

« Les exceptions aménagées conduisent – de fait à une autorisation d’une extension généralisée de la reconnaissance faciale »

Bien que la reconnaissance faciale se trouve par principe bannie de l’espace public, les exceptions aménagées conduisent – de fait à une autorisation d’une extension généralisée de cette technologie. Les impératifs de sécurité, notamment le risque terroriste, ont vraisemblablement motivé la Commission à aménager l’exploitation de cette technologie dans un strict cadre judiciaire (et non de simple prévention d’infractions de manière vague). Mais l’équipement sera réalisé dans les espaces publics et l’efficacité du contrôle judiciaire sera intimement liée à la réelle indépendance des autorités en charge de l’enquête, variable selon les États membres.

Un Comité aux contours à préciser

Un comité européen sur l’intelligence artificielle, composé de représentants des 27 États membres et du contrôleur européen de la protection des données, sera également créé (art. 56 et suivants).

Ce comité, présidé par la Commission, sera chargé de plusieurs missions : a) contribuer à la coopération efficace des autorités nationales de surveillance ; b) coordonner et contribuer aux orientations et analyses de la Commission, des autorités nationales de surveillance et des autres autorités compétentes sur les questions émergentes dans le marché intérieur ; c) aider les autorités nationales de surveillance et la Commission à assurer l’application du règlement. Le comité contribuera de plus à partager les meilleures pratiques entre les États membres, à l’uniformisation des pratiques administratives (dont le fonctionnement des « bacs à sable réglementaires ») et à émettre avis ou recommandations sur les spécifications techniques des normes (art. 57).

« La création d’un tel organie de suivi, avec une mission si large, pose encore à ce stade bien des questions »

La création d’un tel organe de suivi, avec une mission si large, pose encore à ce stade bien des questions. Son poids sur la régulation du marché pourrait être considérable et, en cas de divergence de vues probables entre ses participants, l’on peut s’interroger sur la paralysie possible du dispositif. La technicité très probable de ce comité ne se trouve pas directement balancée par une représentation démocratique ou de la société civile, même si des observateurs (sans qu’ils ne soient énumérés) pourraient être admis.

Et les droits de l’homme ?

Notre ouvrage, « L’intelligence artificielle en procès », plaidait pour une réglementation européenne et internationale de cette technologie. Nous y sommes (presque).

Nous y proposions certaines idées (examen de conformité avant la mise en service, différenciation de la contrainte réglementaire en fonction des cas d’application, cadre juridique d’expérimentation notamment) avec une boussole fortement ancrée vers les droits de l’homme, la démocratie et l’État de droit. L’essentiel de la mécanique s’y retrouve dans cette proposition… au moins en surface. Le texte proposé par la Commission vise en effet, en premier et avant tout, à assurer par principe un développement de cette technologie et non un usage plus modéré, en anticipant notamment des contraintes environnementales.

En ce qui concerne précisément les droits de l’homme, force est de constater, en reprenant la terminologie classique de l’Union européenne, que les droits fondamentaux sont invoqués comme l’une des bases de cette proposition (section 1.1 p.1 et p.3 notamment, et 3.5 p.11), en plus de garantir un fonctionnement harmonieux du marché interne (section 2 p.6 et 7). C’est d’ailleurs sur la base des droits fondamentaux que sont prohibées certaines applications ayant de fortes conséquences sur les individus (art.5).

« Si l’on peut se réjouir de la mention de certains problèmes sous-estimés, l’on voit bien que des questions de principe n’ont pas été traitées »

Si l’on peut se réjouir de la mention de certains problèmes sous-estimés (comme les biais d’automatisation – art. 14, 4, b), l’on voit bien que des questions de principe n’ont pas été traitées, notamment celle de l’opportunité du recours à des algorithmes dans certaines matières comme la police ou la justice. Même si, dans ce domaine à « haut risque », une procédure d’examen de conformité s’appliquera, l’annexe III autorise – de fait – le principe d’un appui de systèmes algorithmiques pour la prise de décision judiciaire, le profilage des individus ou le contrôle aux frontières. A titre d’exemple, rien n’est réellement dit sur l’atténuation concrète des biais ou le degré d’explicabilité attendu, notamment dans ces domaines. La conséquence de cette position sera de ne satisfaire personne en définitive : les défenseurs de droits jugeront comme une régression cette légitimation ; les legaltechs et autres opérateurs privés vont se voir imposer une très lourde mise en conformité sans nécessairement répondre au fond des critiques pouvant leur être adressées (comme le sens des prévisions des logiciels de jurimétrie[18]). Nombre d’applications risquent donc d’être « blanchies » par un dispositif de mise en conformité.

La prohibition du principe de la reconnaissance faciale dans l’espace public, avec de très larges exceptions, relève également de la plus évidente des astuces légistiques[19]. Cette proposition de règlement autorise en réalité une très large diffusion de cette technologie et, comme pour la vidéosurveillance/vidéoprotection, va finir par équiper tous nos espaces publics « au cas où ». Le contrôle de l’autorité judiciaire pourrait être rassurant si elle avait les moyens effectifs de cette nouvelle tâche, sans parler du caractère variable de l’indépendance de ces autorités selon les États membres. La proposition constitue donc potentiellement un recul des droits individuels dans certains États, les exigences sécuritaires de notre société servant de commode justification pour déconstruire nombre de mécanismes pourtant chèrement acquis. Parmi les applications prohibées, l’on peut aussi noter un recul de la Commission entre le leak et le document final : alors que le texte « fuité » mentionnait de manière large les algorithmes pouvant avoir un effet sur les individus et leur manière de se comporter, sur leur manière de former une opinion ou de prendre une décision à leur détriment, le texte final restreint la prohibition aux seuls systèmes pouvant causer des dommages physiques ou psychologiques.

Il doit également être relevé l’absence de mécanisme clair facilitant le recours des individus contre des prises de décision algorithmiques (ou assistées par des algorithmes). Malgré des mesures extrêmement précises concernant la traçabilité des opérations, il aurait été souhaitable que la question de la charge de la preuve en cas de manquement allégué puisse être traité. Démontrer le lien de causalité entre un dommage et les opérations d’un système (ou sous-système d’IA) s’avèrera extrêmement complexe et d’autres évolutions juridiques (notamment en ce qui concerne la responsabilité du fait des produits défectueux) devront intervenir afin de corriger l’asymétrie qui existera entre les parties.

Peut-être de manière plus substantielle, la dimension collective de la transformation numérique de notre société est quasiment absente de ce texte. Il faut dire qu’il s’insère dans une stratégie très offensive de la Commission de développement des technologies numériques et que les notions de frugalité dans le domaine (frugalité des données, de la consommation électrique et énergétique) ne sont probablement au cœur du logiciel politique de la Commission. La prohibition de systèmes de crédit social répond bien à une préoccupation collective, mais la régulation de la propagande à l’ère des réseaux sociaux, le renforcement de la primauté du droit vis-à-vis du développement de nouvelles formes de gouvernementalité (data-driven law par exemple[20]) ou encore le développement d’un principe de solidarité sont notablement absent de cette proposition.

Enfin, si les États membres de diverses organisations internationales ou régionales (Nations Unies et ses agences dont l’UNESCO, OCDE, Conseil de l’Europe, …) ont régulièrement appelé à une coordination entre ces institutions pour bâtir un cadre global de régulation du numérique, la proposition de la Commission s’avère bien solitaire. Même si le texte s’affirme « largement conformes à d’autres recommandations et principes internationaux, ce qui garantit que le cadre IA proposé est compatible avec ceux adoptés par les partenaires commerciaux internationaux de l’UE » (p.13), rien ne démontre cette conformité. S’agissant d’un texte de la Commission, l’on comprend que les références soient réalisées dans l’écosystème de l’UE. Mais n’oublions pas que les négociations pour l’adhésion de l’UE à la Convention européenne des droits de l’homme ont repris : cette possible – et souhaitable – a adhésion entraînera certainement des conséquences sur les dispositions ici proposées et il aurait été rassurant de les voir anticipées.

De manière générale, il est à craindre que cette proposition n’attire en définitive que des critiques de tous les bords[21], oscillant entre le trop ou le trop peu de précisions, et laissant craindre la mise en place d’un cadre juridique légitimant des applications tout à fait critiquables. Créer de la confiance passe par des recours facilités pour les individus, par des mesures sociétales prenant mieux en compte la dimension collective des enjeux du numérique (notamment environnementales) et en imposant une charge de mise en conformité, fondée sur des preuves scientifiques solides, qui soit une réelle valeur ajoutée qualitative.

Magistrat et maître de conférences associé à l’université de Strasbourg

Auteur des ouvrages « L’intelligence artificielle en procès » (Bruylant) et « IA générative et professionnels du droit » (LexisNexis)

Les opinions exprimées n’engagent que son auteur.

[1] Pour mémoire, un tel acte juridique de l’UE sera adopté, en procédure ordinaire, sur décision conjointe du Parlement et du Conseil de l’Union européenne. Plusieurs années seront probablement nécessaires avant cette adoption (il aura fallu presque 4 années pour le RGPD).

[2] L’acronyme d’intelligence artificielle sera présenté par endroits entre guillemets par commodité éditoriale. L’ensemble des technologies recouvertes par ce terme ne constituent naturellement pas une personnalité autonome et, afin de se garder de tout anthropomorphisme, il a été choisi de résumer les termes plus appropriés « d’outils d’intelligence artificielle », « d’applications d’intelligence artificielle » ou de « systèmes d’intelligence artificielle » par le seul terme « d’IA » entre guillemets.

[3] Voir : https://digital-strategy.ec.europa.eu/en/library/new-coordinated-plan-artificial-intelligence – Consulté le 22 avril 2021

[4] Voir édition de la lettre d’information AI :Decoded du 21 octobre 2020 – https://www.politico.eu/newsletter/ai-decoded/politico-aidecoded-europe-divided-the-access-now-files-crunch-time/ – Consulté le 21 avril 2021 et la note blanche de 14 Etats membres de l’Union européenne « Innovative and Trustworthy AI: Two sides of the same coin » – https://em.dk/media/13914/non-paper-innovative-and-trustworthy-ai-two-side-of-the-same-coin.pdf – Consulté le 21 avril 2021

[5] Il sera fait référence dans cette étude à la version anglaise de la proposition et de ses annexes, disponibles sur : https://digital-strategy.ec.europa.eu/en/library/proposal-regulation-european-approach-artificial-intelligence – Consulté le 21 avril 2021

[6] Voir l’opinion de la Daten Ethik Kommission allemande : https://www.bmjv.de/SharedDocs/Downloads/DE/Themen/Fokusthemen/Gutachten_DEK_EN.pdf?__blob=publicationFile&v=1 – Consulté le 21 avril 2021

[7] F. Hidvegi, D. Leufer, E. Massé, The EU should regulate AI on the basis of rights, not risks, Access Now, 17 février 2021 – https://www.accessnow.org/eu-regulation-ai-risk-based-approach/ – Consulté le 21 avril 2021

[8] Il ne sera pas discuté ici des motivations distinctes de la société civile et d’entreprises comme Microsoft sur la régulation de la reconnaissance faciale – Voir M. Tual, Intelligence artificielle : « Microsoft ne veut pas fournir d’outils qui pourraient violer les droits de l’homme », Le Monde, 3 juillet 2018 – https://www.lemonde.fr/pixels/article/2018/07/03/eric-horvitz-microsoft-ne-veut-pas-fournir-d-outils-qui-pourraient-violer-les-droits-de-l-homme_5324975_4408996.html – Consulté le 21 avril 2021

[9] Systèmes énumérés dans l’annexe 1 : « (a) Approches d’apprentissage automatique, y compris l’apprentissage supervisé, non supervisé et par renforcement, utilisant une grande variété de méthodes, y compris l’apprentissage profond ; (b) Approches fondées sur la logique et la connaissance, y compris la représentation des connaissances, la programmation inductive (logique), les bases de connaissances, les moteurs d’inférence et déductifs, le raisonnement (symbolique) et les systèmes experts ; (c) les approches statistiques, l’estimation bayésienne, les méthodes de recherche et d’optimisation.

[10] Proposal for a Regulation on Digital markets act: COM/2020/842

[11] Proposal for a Regulation on a Single Market For Digital Services (Digital Services Act): COM/2020/825

[12] Proposal for a Regulation on European data governance (Data Governance Act): COM/2020/767

[13] Directive (EU) 2019/1024 of the European Parliament and of the Council of 20 June 2019 on open data and the re-use of public sector information: PE/28/2019/REV/1, OJ L 172, 26.6.2019, p. 56–83

[14] Communication de la Commission, Une stratégie européenne sur les données : COM/2020/66 final

[15] Le système de crédit social est un projet du gouvernement chinois visant à mettre en place un système national de réputation des citoyens et des entreprises, inspiré du score de crédit des États-Unis, mais en y ajoutant la pénalisation en cas de non-respect des normes.

[16] Lignes directrices en matière d’éthique pour une IA digne de confiance du groupe d’experts indépendants de haut niveau constitué par la Commission européenne : https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=60427 – Consulté le 21 avril 2021

[17] La liste des infractions pénales visées par l’article 2, paragraphe 2, de la décision-cadre 2002/584/JAI du Conseil est très large, allant de faits criminels graves à des faits délictuels comme l’escroquerie ou l’aide au séjour irrégulier.

[18] Y. Meneceur, Quel avenir pour la « justice prédictive » ?, La Semaine Juridique édition générale n°7, 12 février 2018

[19] Voir le commentaire au Wall Street Journal de Sarah Chander, conseillère politique principale à European Digital Rights : “La liste des exemptions est incroyablement large », cela “va en quelque sorte à l’encontre du but de prétendre que quelque chose est une interdiction” – S. Schechner, P. Olson, Artificial Intelligence, Facial Recognition Face Curbs in New EU Proposal, Wall Street Journal, 21 avril 2021

[20] M. Hildebrant, Data-Driven Prediction of Judgment. Law’s New Mode of Existence?, SSRN, 30 mars 2020 – https://papers.ssrn.com/sol3/papers.cfm?abstract_id=3548504 – Consulté le 22 avril 2021

[21] W. Knight, Europe’s Proposed Limits on AI Would Have Global Consequences, Wired, 21 avril 2021 – https://www.wired.com/story/europes-proposed-limits-ai-global-consequences/ – Consulté le 22 avril 2021